用翻译看了这个论文,很有趣的时间向量,能提升模型的适应性和前瞻预判性。通过在不同的时间向量间进行插值,即使在未经训练的时间段内,也能有更好的表现。

这很像人在思考问题的过程,之前的事儿我想一想,中间的我想一想,进而对今天或未来更准确的判断。将这种思维方式融入到模型的微调中,更接近于模拟人脑的思考过程。非常佩服这些人,居然是本科生,能把这种事儿做得非常精致。

论文:https://arxiv.org/abs/2312.13401

Code:https://github.com/KaiNylund/lm-weights-encode-time

用chatGPT详细解释:

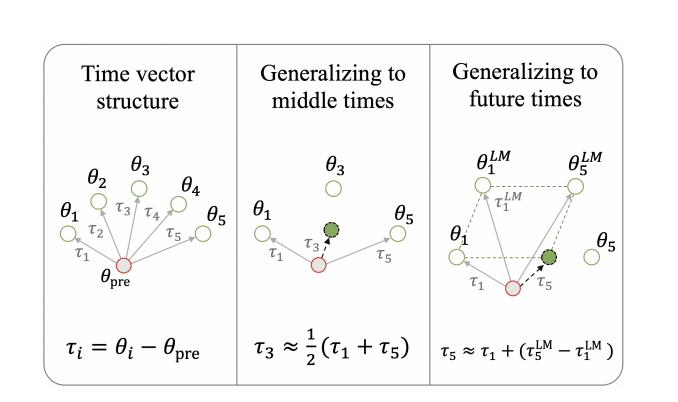

这张图似乎是关于时间序列或者时间点向量的结构及其推广的概念性表示。图中分为三个部分,我们一一来解释:

- 时间向量结构(Time vector structure):

- 这部分展示了一个基于时间点的序列。θ₁,θ₂,θ₃,θ₄和θ₅代表时间序列中的点,可能是事件发生的时间点或者状态的改变点。

- τ₁,τ₂,τ₃,τ₄和τ₅表示从某个基准时间点θ_pre到各时间点的时间间隔。这可以是实际时间差,或者是在某种度量下的时间差。

- 泛化到中间时间(Generalizing to middle times):

- 这部分似乎是在讨论如何估计两个已知时间点之间的时间点(即中间时间)。θ₁和θ₅是已知的,而图中试图估计θ₃的位置。

- τ₃被估计为τ₁和τ₅的平均值,这里使用的是简单的算术平均公式。这可以是在缺少具体数据时的一种估算方法。

- 泛化到未来时间(Generalizing to future times):

- 最后一部分讨论的是如何基于当前已知的时间点来预测未来的时间点。

- τ₅的估计是基于某种线性模型,这里用的可能是一种趋势外推法。θ₁和θ₅是已知的,θ₁^LM和θ₅^LM代表通过某种学习模型得出的估计值。

- 公式 τ₅ ≈ τ₁ + (τ₅^LM – τ₁^LM) 提供了一个预测τ₅的方法,即取已知时间点的时间差,并将其加到τ₁上。

这张图可能是来自于某个关于时间序列分析、预测模型或机器学习中处理时间数据的教程或论文。图中的θ可能代表状态变化的时间点,而τ代表时间间隔。整体来看,这张图试图展示如何从已知的时间点推广到未知的时间点,无论是位于已知点之间还是在已知点之后。